Salió en Slashdot que Pine, el venerable programa de correo electrónico, va a perder su sitio de parches.

Pine tiene en primer lugar un sitio de parches porque no es Software Libre. Se podría discutir si es o no Open Source (yo creo que sí lo es), pero ciertamente no es lo suficientemente libre como para que alguien tome el código y comience a mantenerlo si así lo desea. Se necesita permiso especial de la Universidad de Washington, que es la “dueña” del código.

En general, esta noticia no me interesa en lo más mínimo; pero me hizo recordar mi breve uso de Pine al inicio de la carrera, y los distintos clientes de correo electrónico que he utilizado desde que tengo correo… que son sorprendentemente pocos, por cierto (descontando clientes webmail).

Al inicio de la carrera yo no utilicé mi correo electrónico. No lo necesitaba en ese entonces; no conocía a nadie fuera de la Facultad que usara correo electrónico, y dentro de la Facultad no era necesario utilizarlo: la única materia de la carrera era Matemáticas Discretas, y ahí no había laboratorio. En las materias de Matemáticas era aún menos necesario.

Comencé a usar mi correo (cpelaez@ada.fciencias.unam.mx, creo que aún sirve, por cierto) hasta segundo semestre cuando tuve mi primer materia de la carrera que necesitaba laboratorio. Siguiendo a la manada, utilicé Pine para leer mi correo; casi todos los newbies era lo que usábamos.

Pine sin duda alguna funcionaba. Era feo y triste; pero era puro amor. Yo creo que hubiera seguido usándolo si no fuera por dos razones: comencé a utilizar mucho Emacs (todavía no XEmacs, creo), y descubrí con horror que meter acentos en Pine era ligeramente engorroso. Era 1998.

Como a mí siempre me ha interesado escribir en español, no en espanol, y como ya había descubierto cómo escribir caracteres acentuados y eñes en Emacs, no tardé mucho en descubrir rmail y pasarme de volada a ese cliente. Rmail, debo hacer la aclaración por si no es obvio, es un programa escrito en elisp, y que corría dentro de Emacs.

Eso tiene ventajas y desventajas. Las ventajas son obvias; uno utiliza Emacs para escribir correos. Todo el poder de Emacs (y elisp) están ahí para que uno pueda escribir los tres párrafos que en promedio tiene un correo. Las desventajas también son obvias: uno utiliza Emacs para escribir correos. Todo el consumo de memoria y procesador que utiliza Emacs son necesarios para escribir los tres párrafos que en promedio tiene un correo.

Rmail funcionaba. Mejor que Pine, debo decir, si bien le faltaban ciertas cosas que cualquier cliente de correo moderno tiene: en particular hilos (threads); que una serie de correos sobre un mismo tema se aniden. En rmail (y Pine, en esa época) todos los correos sencillamente aparecían uno detrás del otro. Eso era inconveniente, por decir lo menos. Especialmente si uno comenzaba a suscribirse a listas de correo como degenerado, que fue lo que yo hice.

Por esa razón, y porque me mudé a XEmacs, decidí pasarme a Gnus. Gnus también corría dentro de XEmacs, pero tenía soporte para hilos (dado que, originalmente, era un cliente para news, no para mail), y de hecho tenía una cantidad ridícula de cositas que lo hacían increíblemente poderoso. A partir de que comencé a usar Gnus, de vez en cuando veía otros clientes de correo electrónico, pero era dolorosamente obvio que ninguno le llegaba a los talones a Gnus.

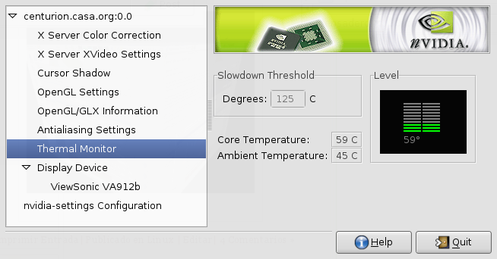

Y así seguí durante años; y tal vez así hubiera seguido si no fuera por una combinación de circunstancias. La primera es que comencé a usar GNOME en serio, y quería un cliente de correo que utilizara Gtk+ 2. La segunda es que descubrí GnuPG, y quería empezar a firmar digitalmente mis correos. Con este punto debo hacer la aclaración de que estoy seguro de que se puede utilizar GnuPG con Gnus… y también estoy seguro de que en ese entonces (hace unos tres años) era una desmadre hacerlo. La tercera circunstancia es que en Gnus es, para motivos prácticos, imposible mover un correo de una “carpeta” a otra. Lo cual tiene sentido si uno comprende que Gnus no era originalmente un cliente de correo, sino uno de news.

Gnus por lo demás hacía todo lo que ahora hago con Evolution; se podía filtrar SPAM con SpamAssassin, se podía poner cualquier script para generar firmas (lo que va al final del correo; yo utilizo fortunas), etc. Y ciertamente fue Evolution el primer cliente que encontré que hacía eso y más. O lo hacía más fácil; por ejemplo, en Gnus borrar un correo era particularmente engorroso (una vez más, legado de ser un cliente de news originalmente).

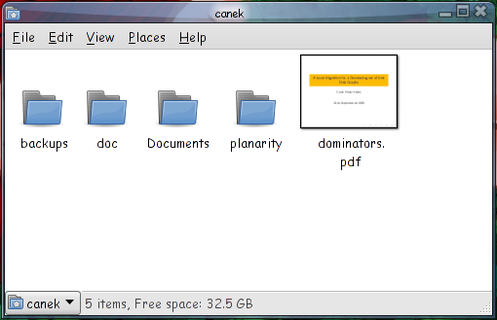

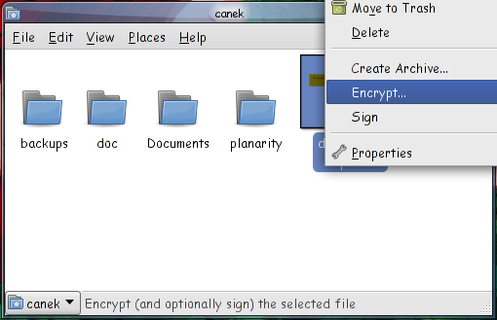

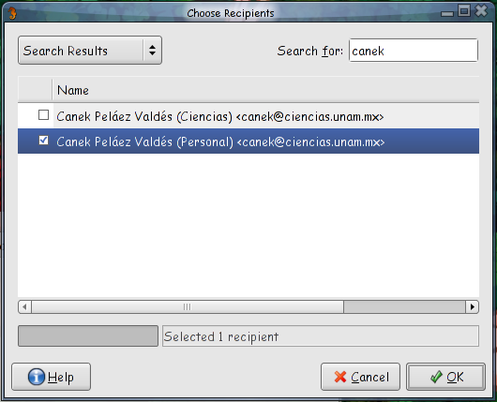

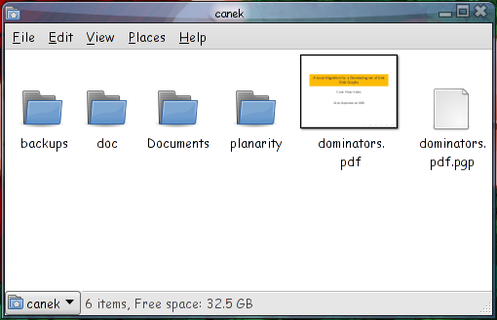

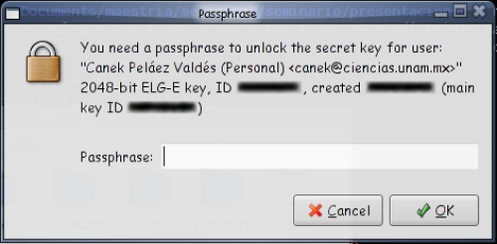

Evolution me gusta bastante; se integra sin ningún problema con GnuPG y con SpamAssassin; mis contactos y calendario se sincronizan con mi Palm; puedo utilizar cualquier script para firmar mis correos; puedo verificar firmas digitales apretando un botón; firmo digitalmente mis correos de forma transparente; si así lo deseo puedo cifrar un correo completamente; etc., etc., etc.

Evolution también tiene sus broncas, claro. En primer lugar, sí es pesado en memoria y procesador. Y en segundo lugar, sí me gustaría tener un cliente de correo electrónico, un programa para manejar contactos, un programa para mi calendario y un programa para memos y lista de tareas; no tenerlo todo junto en un programa enorme.

Pero quitando eso, es un excelente cliente de correo electrónico.

Ahora, lo obvio es preguntar: ¿por qué no utilizar un cliente de webmail? Sí lo utilizo, y el que yo creo que es el mejor: GMail; pero no es mi correo electrónico principal.

Las razones son varias. Primero, aunque GMail da tres gigas (casi) de espacio, el punto es que tengo espacio limitado. Si quiero conservar mis correos para siempre, lo único que me garantiza espacio suficiente es tenerlos en una máquina que yo controle. Segundo, no hay manera de usar GnuPG, a menos que yo a pie cree los adjuntos necesarios al correo, lo cual está de hueva. Y tercero; estoy muy orgulloso de que mi correo termine con “unam.mx”, y es algo que no quiero dejar de usar nunca para mi correo principal. Que además sea “ciencias.unam.mx” es un bono extra.

Las ventajas de un correo webmail son obvias; principalmente la capacidad de consultar y responder o mandar correos desde cualquier máquina con un navegador. Mi cuenta en Ciencias tiene un cliente web, que utilizo para emergencias. Para otras cosas, como listas de correo y cosas así, utilizo mi cuenta de GMail (no quiero guardar en mi máquina mis correos de listas; ya hay archivos en la red).

Pero mi correo principal, el que uso exclusivamente para cosas académicas y con el que uso Evolution como cliente, es el de Ciencias. Y Evolution es un gran cliente de correo electrónico.

No sé si eventualmente aparezca un mejor programa (ya no llegué a probar Thunderbird, por ejemplo), pero a menos que Evolution me de algún tipo de problema, yo creo que seguiré usándolo indefinidamente.