Hace seis años platiqué cómo utilizaba una vieja estéreo de mi hermano como “bocinas” de mi computadura. Bueno, hasta hace dos semanas esa misma (cada vez más) vieja estéreo siguió desempeñándose como las “bocinas” de mi computadora de escritorio. Y creo que hubiera podido seguir haciéndolo durante varios años más; jamás me dieron problemas.

Un par de meses después de esa entrada, escribí cómo me compré mi televisión de 46″. Mi televisión es de las posesiones más preciadas que tengo, y jamás he tenido ningún problema con ella. En algún momento va a fallar (porque así es la naturaleza de las cosas), y entonces estaré muy triste… por unos cinco minutos, porque después me va a dar el pretexto para comprarme una nueva más grande.

Como sea, mi televisión es maravillosa, pero sus bocinas, para mí, suenan como las ardillas de Alvin y las ídem. En algún momento me compré unas bocinas Logitech X-540, originalmente para mi computadora; pero ya con la televisión, decidí que prefería utilizarlas para ver cosas en mi telesota, y para jugar videojuegos.

La verdad, no sé si fue buena o mala idea; hasta hace dos semanas que radicalmente cambié la configuración de bocinas en mi departamento, no se me había ocurrido que a lo mejor hubiera sido más inteligente usar las bocinas en mi computadora, y la viejo estéreo de mi hermano para la tele. No soy fanático del sonido; me gusta que las cosas suenen ferte, y que no se oigan distorsionadas: fuera de ahí, mi entendimiento de audio no da para mucho. En ese sentido, la verdad no sé distinguir cuál suena mejor entre las bocinas Logitech o la vieja estéreo de mi hermano. Lo que sí sé es que las bocinas Logitech son un sistema 5.1 (5 satélites y un subwoofer, ergo el .1), y que la estéreo de mi hermano es, bueno, estéreo, sólo 2 bocinas. Me imagino que por eso decidí usar las Logitech en mi telesota… lo cual por supuesto es idiota, porque lo que hacía era conectar la salida de audio de mi tele a las bocinas, así que sólo funcionaban en estéreo, aunque hacía que se replicara el sonido a los satélites traseros… inútilmente, porque tenía los cinco satélites básicamente atrás de la tele: 4 en la pared, y el central arriba de la misma.

De cualquier forma, funcionaba y la verdad se oía bien. Tal vez no maravillosamente bien, y ciertamente nunca tuve realmente surround sound, pero tapaba el parche, y además en mi computadora tenía la estéreo, que para oír música mientras trabajo bastaba y sobra. Pude haber vivido así hasta que alguna parte fallara, pero como estoy ganando bien, decidí que ya era hora de comprarme un AVR.

Un AVR (audio/video-receiver) permite conectar varias entradas HDMI, puentearlas a una televisión (vía HDMI una vez más), y encargarse del sonido de manera mucho más profesional que una vieja estéreo o que unas bocinitas Logitech, 5.1 o no 5.1. Había estado coqueteando con la idea de comprarme uno, porque (además de que creo que es un lujo, pero me lo merezco) he considerado regalarme un PlayStation 4 de navidad, y entonces ya estaría en el límite de entradas HDMI que mi tele soporta. Además, harto más ferte, como mencionaba arriba.

Como ya expliqué, no soy fanático del sonido; no tengo ni puta idea de qué marcas o qué especificaciones son las mejores en esto, así que fui a comprar mi AVR con sólo unas cuantas ideas vagas: Bose es muy bueno, pero excesivamente caro; Sony es bueno, pero probablemente más caro de lo que ofrece; y Onkyo ahí se va en calidad y precio. Igual y estoy diciendo puras pendejadas, pero eso es lo que saqué de mi superficial investigación. Obviamente, siendo como soy, cuando llegué a la tienda a ver AVRs (en conjunto con un sistema 5.1; en mi departamento de medio metro cuadrado, 7.1 es completamente inútil), iba determinado a comprarme un Onkyo.

Pero entonces ocurrió algo que me pasa muy pocas veces: el chavo que me atendió era competente. No sólo era competente; estaba muy bien informado, y (para mí muy importante) me supo resolver mis dudas muy bien. Estaba debatiéndome entre el AVR Onkyo que había pensado comprar, y el AVR que a final de cuentas me compré, y el muchacho me explicó que el primero tenía un subwoofer pasivo, mientras el segundo era activo. “No entiendo”, le dije, “¿cuál es la diferencia?”; el muchacho sencillamente procedió a mostrarme la conexión del subwoofer Onkyo (dos simples cables con la señal de audio), y la del otro (un cable RCA que permite transmitir información aparte de la señal de audio). Así que compré el otro, del cual jamás había oído la marca. Y no estoy exagerando; jamás la había oído, y si llegué a hacerlo procedí a olvidarlo de inmediato. Estaba seguro de que era una marca piratísima.

La marca es Harman Kardon, y resulta que no sólo no es piratísima, sino que al parecer todo mucho excepto yo había oído hablar de ella.

Así que conecté el Harman Kardon a mi tele, mi media center, PlayStation 3 y servidor Atom al Harman Kardon (me sobran entradas HDMI, así que puedo hacerlo), coloqué los satélites traseros atrás, los delanteros adelante y el central al centro (y aún así no sigo las ridículamente detalladas instrucciones del manual), y lo prendí. Y ay güey.

Además de que mi pobre departamento parece estar a punto de derrumbarse cada vez que subo mucho el volumen, la calidad del audio (para un lego como yo en asuntos de sonido) es ridículamente superior a la que tenían las bocinitas Logitech… aunque siendo justos eso probablemente no sea únicamente culpa de ellas, como ahorita explicaré.

Procedí a mover las bocinas Logitech a mi computadora, porque quiero deshacerme de la vieja estéreo: ocupa mucho espacio, y estoy seguro que también electricidad, además de que se calienta demasiado. Al mover el subwoorfer de las bocinas Logitech, mis dedos rozaron el círculo elástico que sostiene al cono de la bocina (el que permite que “rebote” cuando los bajos están duro que dale; el “surround” en este diagrama), y éste procedió a, literalmente, deshacerse entre mis dedos.

No sé cuánto llevaba deteriorándose sin que yo me diera cuenta (como casi todos los subwoofers, esta bocina apuntaba al piso), pero dado que lo he venido usando desde hace años, tampoco me extraña que lo hiciera. Por suerte lo llevé al centro donde me lo repararon por 150 pesos que, como las bocinas me costaron unas diez veces eso, me parece un muy buen precio. Ahora suenan como nuevas, pero sí siguen sin poder compararse al Harman Kardon.

Así que ahora tengo dos sistemas 5.1 funcionando perfectamente; uno decente (pero bastante normal) en mi computadora, y otro muy bueno en mi televisión en conjunto con mi media center y PS3 (y posiblemente en el futuro, PS4).

De las primeras cosas que hice fue ver una película Blu-ray (Splice; está simpática, sí la recomiendo). En una escena, ocurre un ruido pertubador “atrás” de la misma. Nunca había tenido un sistema surround sound propiamente instalado en mi departamento; así que cuando oí el ruido viniendo de la cocina, además de friquearme bastante, tardé varios segundos en percatarme de que era la película. No ayudó que fuera de terror.

Eso está padre; pero la verdad me hubiera bastado con poder escuchar punchis punchis punchis punchis, y sentir que mi pobre departamento se colapsa con las vibraciones del subwoofer.

No creo que mis vecinos me quieran mucho en estos días.

Imprimir entrada

Imprimir entrada

Imprimir entrada

Imprimir entrada

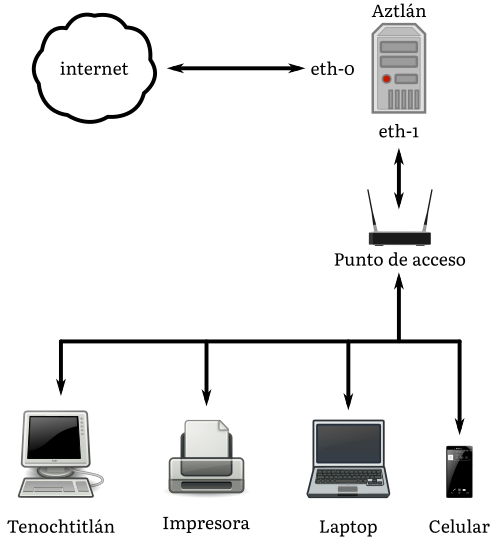

en ese monitor, lo que me permite ver una hoja en tamaño mucho mayor al natural.

en ese monitor, lo que me permite ver una hoja en tamaño mucho mayor al natural.